こんにちは!サキナオコです^o^

また寒いこと。

さあ、まだやってました。StableDiffusion。

Stablediffusionは1.5とか2とかXLがあるんですよね。それで、それぞれに合ったモデルやら機能拡張やらがあって、そのバージョンに合ったものをいれないといけないわけです。

で、1つのStableDiffusionWebUIアプリにSD1.5とSDXLを混在させてもいいのかとGPTに聞いたところ、混在はいいけどモデル切り替えが煩雑、分けたほうが、用途ごとに起動時間や処理時間を最適化でき、拡張機能や設定の干渉を避けられる。

とのことで管理しやすく使いやすくなりそうです。ということで、フォルダも分けて管理したいので、先日インストールしたばかりのSDをモデルと機能拡張以外を削除しました。

SDXL用とSD1.5用のフォルダを新たにつくって、それぞれにStableDiffusionWebUIアプリを入れます。

SDXL用は以下のようにして設定。

無駄な記載は整理しました

よけていたモデルをmodels-Stable-diffusionの中へいれ、機能拡張はよけていたのを移動したところなんかおかしかったので、いったん削除して、git cloneしました。

こちら参照くださいな

それで大丈夫そうです。

何度もやってだいぶ早くできるようになってますよ!^^

はい、で次、1.5です。これは普通にSD1.5用のフォルダにStable-diffusion入れるだけですね。それでcontrolNET入れますが、これもXLの時と同じですね。

違うのはそれから、モデルを入れるとき。

✅ SD1.5用 ControlNetの導入手順

SDXLとは別フォルダのWebUIなので、ControlNetも新たにクローン&チェックポイント配置します。

🔁 手順1:ControlNet拡張を導入(SD1.5用WebUIに)

bashコピーする編集するcd C:\AI\sd-webui-sd15\extensions

git clone https://github.com/Mikubill/sd-webui-controlnet.git

またはWebUI上から「拡張機能」→「URLからインストール」でも可

📦 手順2:ControlNetモデル(SD1.5用)をダウンロード

モデルは .pth または .safetensors

※SD1.5とSDXLでは使うモデルが別なので注意!

| モデル例 | 内容 | 配布URL |

|---|---|---|

control_sd15_canny.pth | 輪郭検出 | Hugging Face (lllyasviel) |

control_sd15_openpose.pth | ポーズ検出 | 同上 |

control_sd15_depth.pth | 深度マップ | 同上 |

control_sd15_scribble.pth | ラフスケッチ | 同上 |

➡ 保存先:

C:\入っているフォルダ\sd-webui-sd15\models\ControlNet\

🔁 手順3:WebUIを再起動 → ControlNetタブが表示される

🔧 ControlNetが効いているかの確認ポイント

- 起動後のログに

ControlNet preprocessor location: ...が出る - WebUI上に

ControlNetタブが出現する - モデル読み込み欄に

control_sd15_***.pthが表示されていれば成功

✨ おまけ:おすすめ構成(SD1.5)

| 拡張名 | 用途 | 備考 |

|---|---|---|

| ControlNet(SD1.5用) | ポーズ・線画など制御生成 | 必須級 |

| After Detailer | 顔の自動修正・顔LoRA連携 | SD1.5で超便利 |

| LoRAエクスプローラー | LoRA管理のUI強化 | 数が増えたら導入推奨 |

サキナオコメモ*一気にSD1.5へVAEも入れる

ℹ️ VAEの役割について

VAE(Variational Autoencoder)は、Stable Diffusionにおいて画像の潜在空間とピクセル空間の間での変換を担います。具体的には:

- エンコード:画像を潜在空間に圧縮

- デコード:潜在空間から画像を復元

これにより、生成される画像の品質、特に細部や色彩の再現性が向上します。特に「vae-ft-mse-840000-ema-pruned」は、顔のディテールや肌の質感の再現に優れており、リアルなポートレート生成に適しています。

サキナオコメモ*VAEは映えるってことでいいんですね

手順

下記リンクから.safetensorsファイルをダウンロード:

vae-ft-mse-840000-ema-pruned.safetensors

ファイルを以下のフォルダに移動:

stable-diffusion-webui/models/VAE/Web UIを開き、「Settings」→「Stable Diffusion」→「SD VAE」から選択

「Apply settings」→「Reload UI」

とこれでとりあえずはオッケーだと思います。あとはLoraとかほかのモデル入れようと思います!

あ、それとこの機能拡張もいれよっと。顔や手の崩れを補正するらしいです。

✅ After Detailer(SD1.5用)の導入手順

🔁 ステップ1:拡張機能をクローンする

bashコピーする編集するcd C:\AI\sd-webui-sd15\extensions

git clone https://github.com/Bing-su/adetailer.git

※SD1.5用にインストールしたWebUIの extensions/ フォルダ内へ。

イメージブラウザを追加する

extensionsタブからInstall from URLタブのURL for extension’s repository以下入れて(GPTリンク間違ってたのでしばらく沼った。自分の記事にURLあった)

https://github.com/AlUlkesh/stable-diffusion-webui-images-browserInstall – Installedタブ – Apply and restart UI で最初の画面のタブに出てきます

記しといてよかった

GPTの言うURL入れたらauthorizeの画面が出て、こんなの出たことないと思ってGPTに聞くとそれは「悪意のあるものではないが、GitHubのアカウント権限を広く渡すことになるため注意」とか恐ろしいことを言うじゃありませんか。

それで前やっていたので自分の記事を探すとありました。ALUlkeshのところがAUTOMATIC1111になってたんですよ。んもう!

ちょいちょい違うので、信じすぎてはいけません。

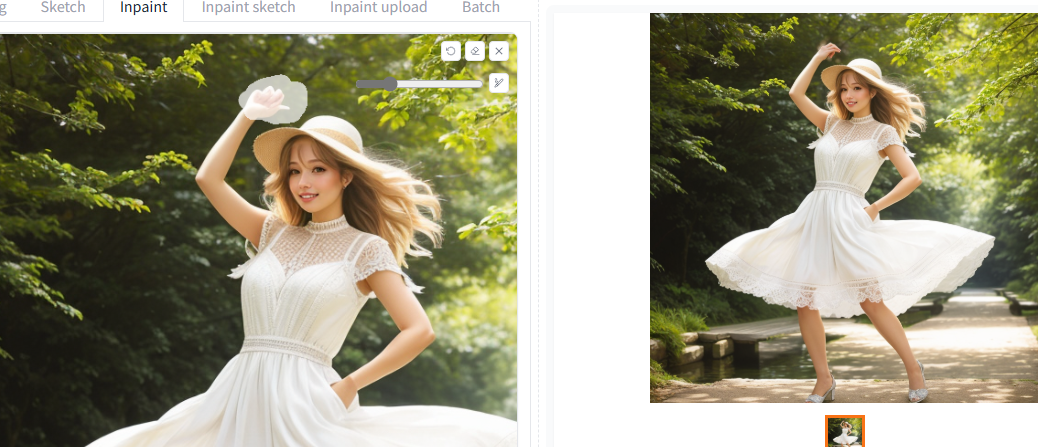

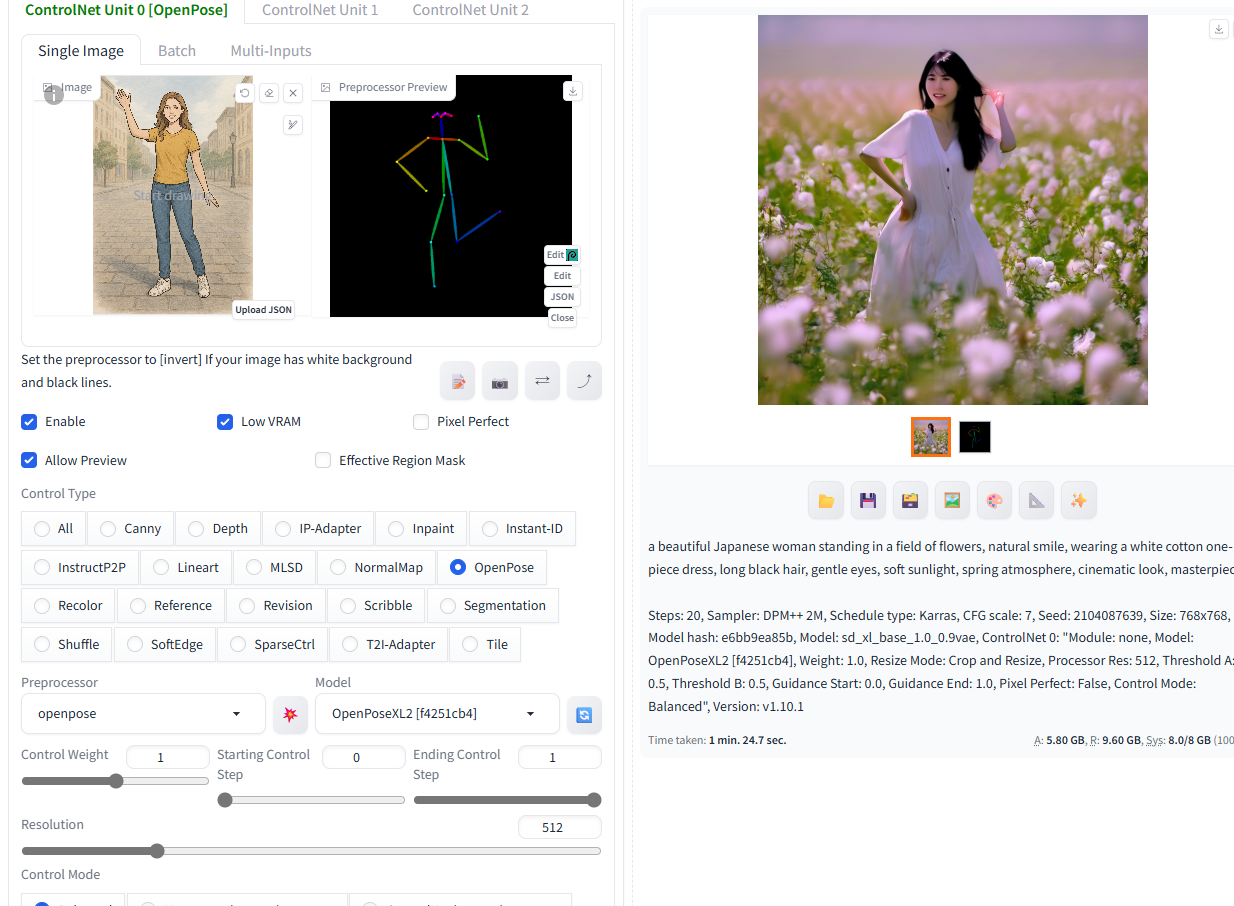

とそんなこんなで無事環境を分けられました。controlNETでポーズをとらせたり、inpaintというもので崩れた顔を直したりして、今日は終了いたします。

コメントを残す